ВВЕДЕНИЕ

Бинарная классификация является одной из фундаментальных задач машинного обучения. В данной работе рассматривается задача предсказания пола человека на основе двух характеристик: роста и веса. Датасет содержит данные о росте (в сантиметрах), весе (в килограммах) и половой принадлежности (мужчина или женщина).

Целью исследования является сравнение производительности различных архитектур нейронных сетей для решения этой задачи. Рассматриваются три типа моделей: полносвязная сеть (Dense), сверточная сеть (CNN) и трансформер (Transformer).

АНАЛИЗ ДАТАСЕТА

Датасет состоит из трех колонок: рост (Height), вес (Weight) и пол (Sex). Пол представлен как бинарный признак с двумя значениями: "male" и "female".

ПОДГОТОВКА ДАННЫХ

Данные были нормализованы с использованием стандартизации, после чего были разделены на обучающую и тестовую выборки в соотношении 80/20.

АРХИТЕКТУРЫ НЕЙРОННЫХ СЕТЕЙ

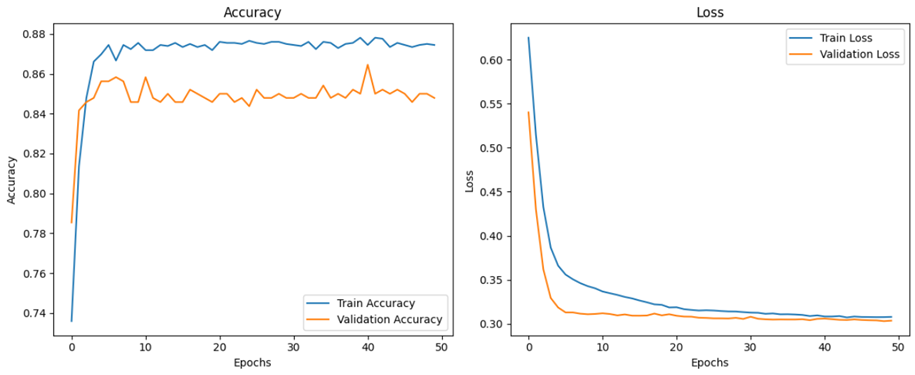

1. Полносвязная сеть (Dense) Модель состоит из трех слоев Dense с функцией активации ReLU и выходным слоем с сигмоидной активацией для бинарной классификации.

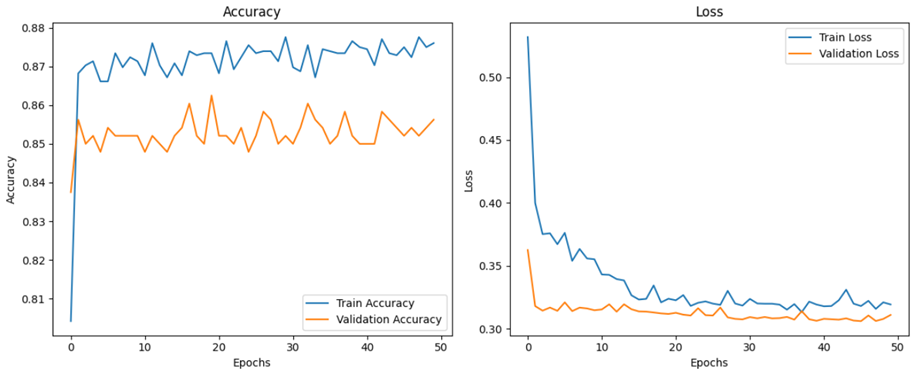

2. Сверточная сеть (CNN) Модель включает один слой Conv1D с функцией активации ReLU, за которым следует слой Flatten, Dense слой и выходной слой с сигмоидной активацией.

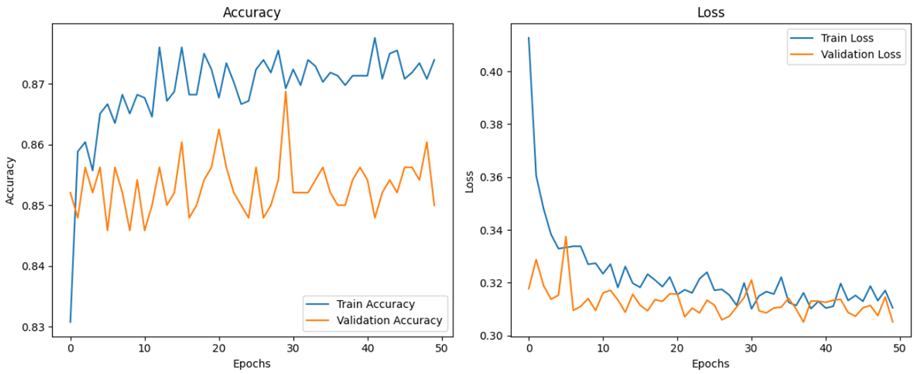

3. Трансформер (Transformer) Модель использует слой Multi-Head Self-Attention, за которым следует слой глобального усреднения, Dense слой и выходной слой с сигмоидной активацией.

ОБУЧЕНИЕ И ОЦЕНКА

Каждая модель обучалась в течение 50 эпох с использованием функции потерь binary_crossentropy и оптимизатора Adam. Для оценки моделей использовалась метрика точности (accuracy).

РЕЗУЛЬТАТЫ

Точности моделей на тестовой выборке:

• Полносвязная сеть (Dense): 86.33%

• Сверточная сеть (CNN): 86.50%

• Трансформер (Transformer): 86.33%

Результаты показывают, что все три архитектуры достигли схожей точности при решении задачи бинарной классификации на основе данных о росте и весе. Немного лучшую производительность показала сверточная сеть (CNN), что может быть связано с ее способностью выделять локальные особенности данных.

Интересно отметить, что использование трансформеров, которые обычно применяются для обработки последовательных данных, не дало значительного улучшения по сравнению с более простыми архитектурами, такими как Dense и CNN. Это может быть связано с небольшой размерностью входных данных и их простой структурой.

ЗАКЛЮЧЕНИЕ

В данном исследовании были рассмотрены три различных архитектуры нейронных сетей для решения задачи бинарной классификации. Полученные результаты демонстрируют, что все три подхода могут быть успешно применены для данной задачи, при этом сверточная сеть (CNN) показала незначительное преимущество по точности. В будущем исследование можно расширить на более сложные датасеты и другие архитектуры моделей.

ПРИЛОЖЕНИЕ

https://github.com/ilushaKolosov/ScienceWeek/blob/main/ScienceWeek.ipynb

Список литературы

- Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep Learning. MIT Press

- Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., ... & Polosukhin, I. (2017). Attention is all you need. Advances in neural information processing systems, 30

- LeCun, Y., Bengio, Y., & Hinton, G. (2015). Deep learning. Nature, 521(7553), 436-444